ollama使用与Mac部署Deepseek

ollama 命令行速查

- 拉取模型到本地:

ollama pull [模型名] - 列出本地模型列表:

ollama list - 从本地删除模型:

ollama delete [模型名] - 启动本地对话 (终端):

ollama chat [模型名] - 启用 RESTful API 服务,供其他程序调用模型:

ollama serve - 直接生成模型对给定输入的回复:`ollama generate [模型名] -p “[提示词]”

- 清理临时文件,不删除模型:

ollama clean - 查看 ollama运行状态:

ollama status - 停止 ollama 服务:

pkill -f "ollama serve"

调用 API:curl -X POST http://localhost:11434/api/v1/completions \ -H "Content-Type: application/json" \ -d '{ "model": "[你的模型名]", "prompt": "[你想说的话]" }'本地部署 Deepseek

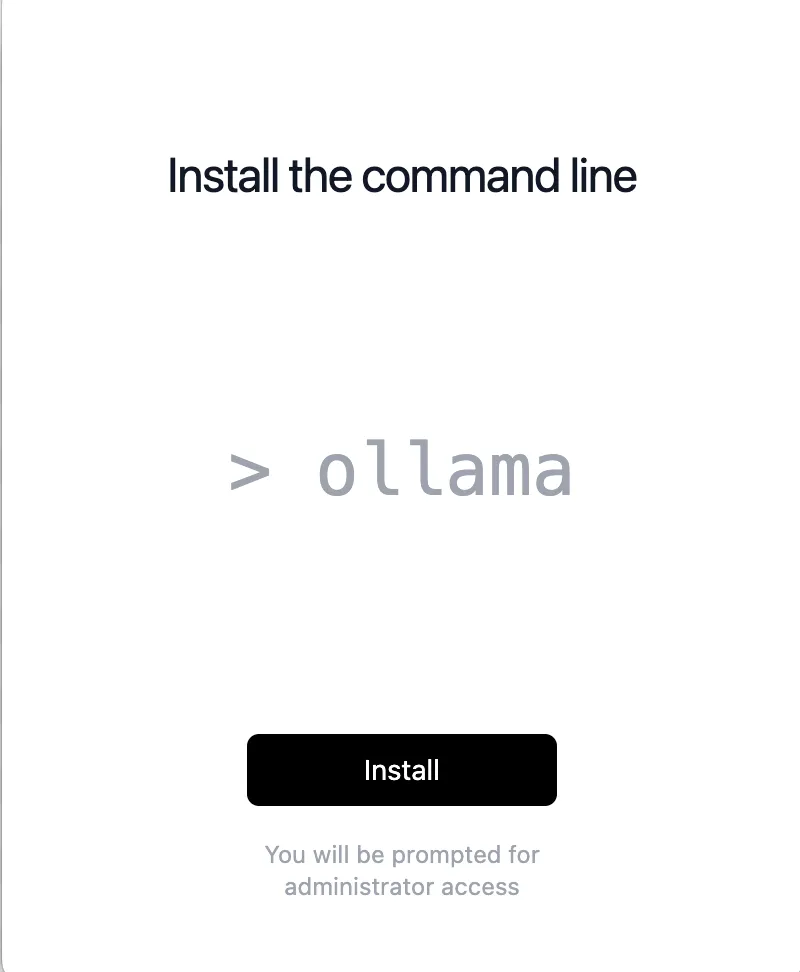

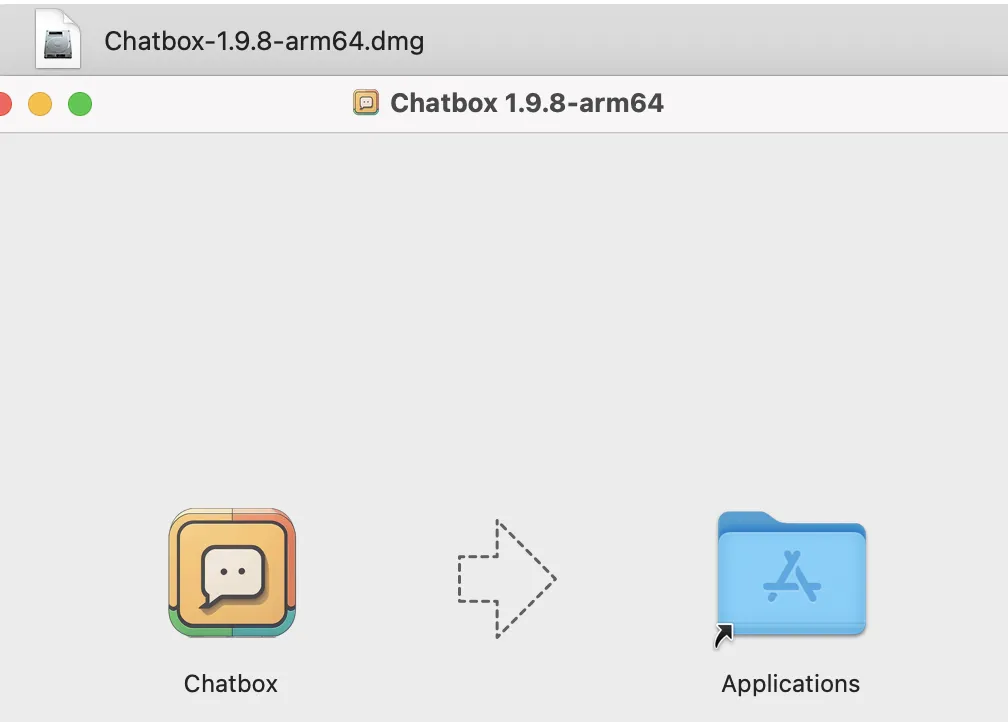

首先需要安装 ollama:https://ollama.com/download可以下载符合个人操作系统的版本。下载后解压,并拖到”应用程序”,即/Applications文件夹

然后在任意本地终端使用命令:ollama run [你要的模型]即可

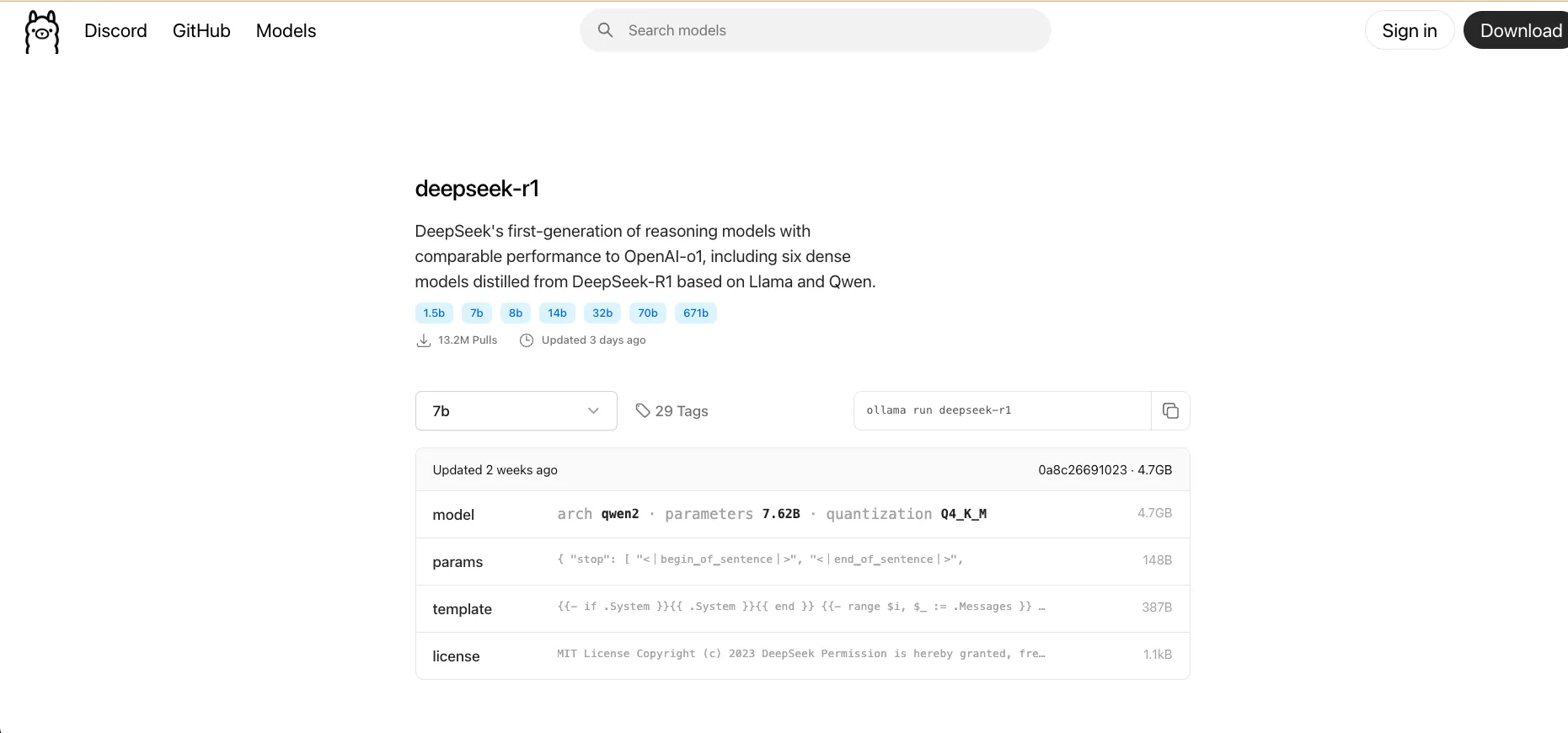

对于 deepseek-r1 而言,访问:https://ollama.com/library/deepseek-r1可以看到如下界面:

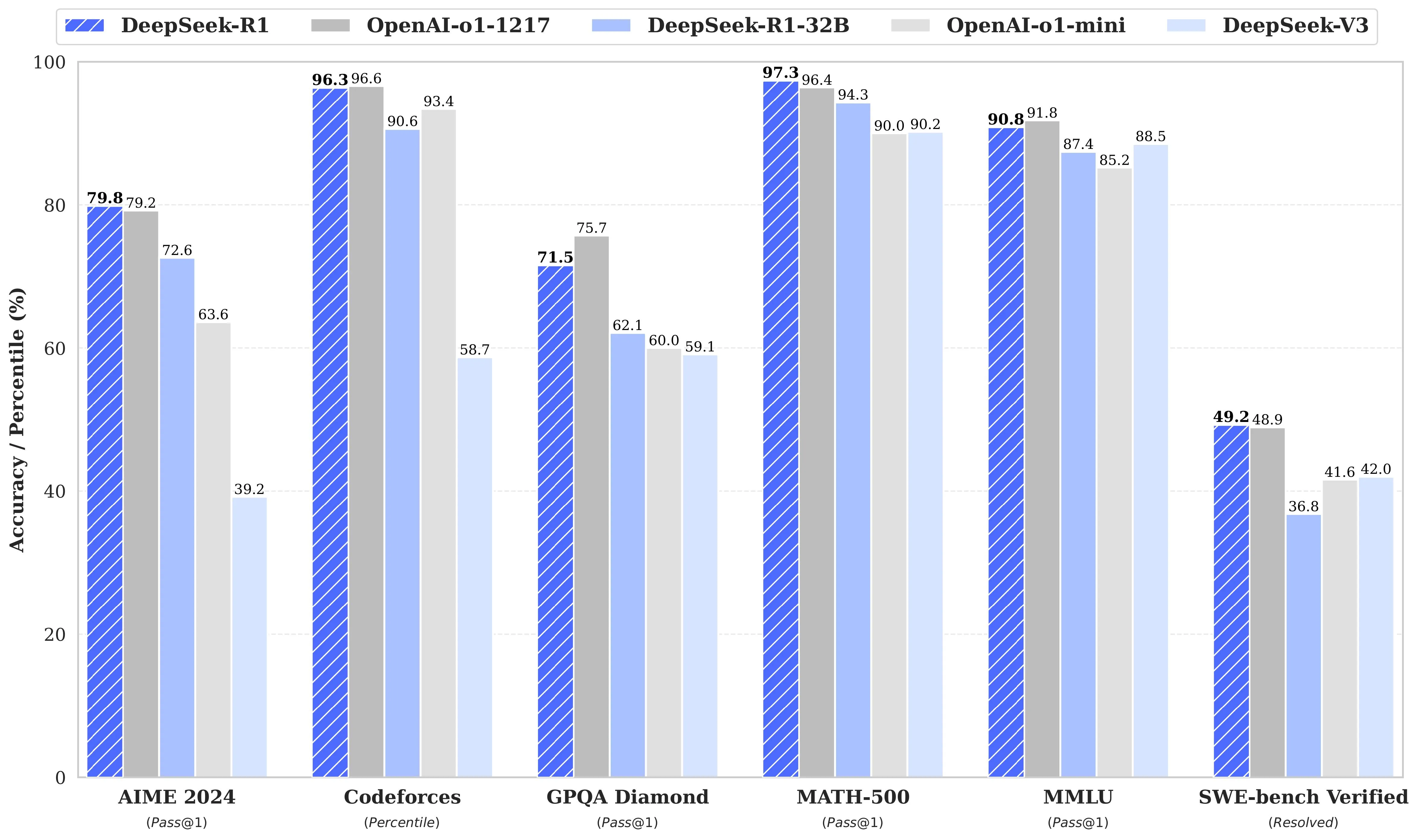

我的 Mac 内存大小为 36GB,因此使用 32B 模型:

在终端使用ollama run deepseek-r1:32b得到的日志如下:

然后去下载可以可视化问答的 App,❯ ollama run deepseek-r1:32b pulling manifest pulling 6150cb382311... 100% ▕████████████████████████████████████▏ 19 GB pulling 369ca498f347... 100% ▕████████████████████████████████████▏ 387 B pulling 6e4c38e1172f... 100% ▕████████████████████████████████████▏ 1.1 KB pulling f4d24e9138dd... 100% ▕████████████████████████████████████▏ 148 B pulling c7f3ea903b50... 100% ▕████████████████████████████████████▏ 488 B verifying sha256 digest writing manifest success >>>https://chatboxai.app/en/install,如果你只要测试问答,可以忽略以下步骤。

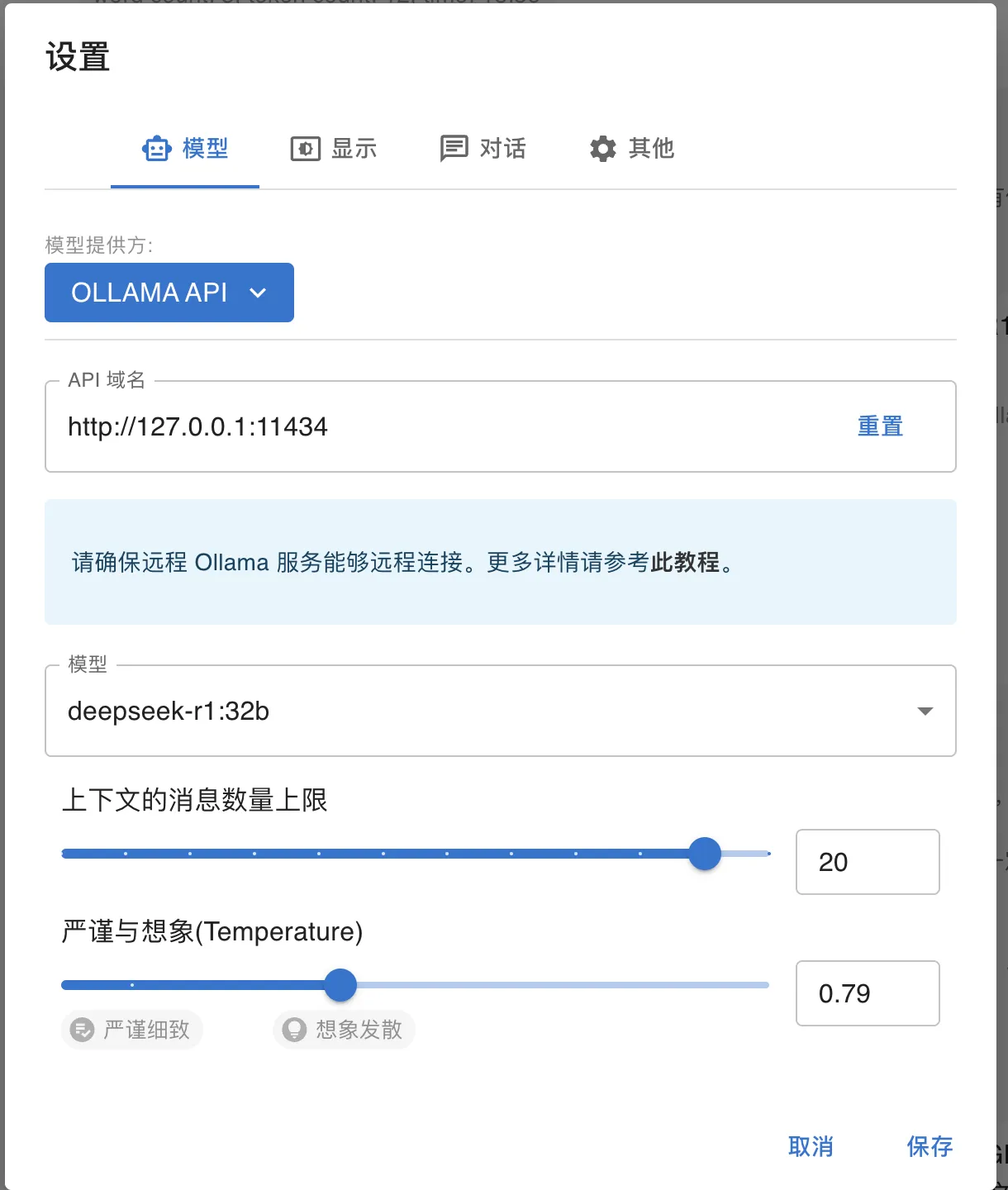

安装完毕后打开,需要配置本地 ollama 服务的接口,打开设置根据需要配置:

然后即可新建对话了!例如:

参考文献

评论